Um beim Einsatz von AI Agents Ihren Ruf zu schützen und teuren Rechtsrisiken zu vermeiden ist es essentiell zu verhindern, dass erfundene Informationen in Form von Halluzinationen ausgegeben werden.

Dieser Praxis-Guide erklärt, warum Large Language Models halluzinieren und welche Maßnahmen helfen, das zu unterbinden.

Halluzinationen bei Chatbots & Voicebots verhindern

Im Kundenservice sind AI Agents wie Chat- und Voicebot längst nichts Neues mehr. Mithilfe von Large Language Modellen erzielen diese mittlerweile eine besonders natürliche und effektive Kommunikation, doch damit kommt auch eine ernstzunehmende Herausforderung. Denn AI Agents neigen zu Halluzinationen. Wenn Chatbots oder Voicebots halluzinieren, erfinden sie Informationen, die zwar plausibel klingen, aber auf keiner faktischen Grundlage basieren. Und da ist Vorsicht geboten, denn diese Phänomene sind weit mehr als einfache Programmierfehler.

Genau das passierte 2024 bei Air Canada, als ein Chatbot einem Kunden eine nicht existierende Rückerstattungsrichtlinie für einen Flug versprach. Die Fluggesellschaft musste für diesen Fehler aufkommen und dem Kunden die Rückerstattung dennoch zahlen. Solche Vorfälle verdeutlichen, dass die Risiken von Halluzinationen über eine unzufriedene Kundenanfrage hinausgehen: Sie bedrohen Ihren Ruf, können kostspielige rechtliche Konsequenzen nach sich ziehen und führen zu operativer Ineffizienz, da Ihre Mitarbeiter die Fehler der KI korrigieren müssen.

Um Halluzinationen bei Chatbots und Phonebots gezielt vermeiden zu können zeigen wir Ihnen in diesem Praxis-Guide, wie Sie mit dem 4-Säulen-Modell bestehend aus Smart Chunking, Retrieval-Augmented Generation (RAG), intelligenten Guardrails und Human-in-the-Loop-Prozessen Ihre KI-Assistenten zuverlässig, vertrauenswürdig und zukunftssicher machen.

Was sind KI-Halluzinationen bei Chatbots und Voicebots?

Halluzinationen entstehen beim Einsatz von Large Language Modellen (LLMs), die im Kern als Wahrscheinlichkeitsmaschinen funktionieren. LLMs wurden darauf trainiert, riesige Textmengen zu analysieren und Muster zu erkennen, um dann das statistisch wahrscheinlichste nächste Wort vorherzusagen, das eine kohärente, menschenähnliche Aussage bildet. Genau diese Vorhersage-Fähigkeit ist die Wurzel des Problems.

Das Modell strebt nach einer plausibel klingenden Antwort, nicht zwingend nach einer faktisch korrekten.

Wenn ein LLM in seinen Trainingsdaten oder im direkten Kontext keine klare Information findet, füllt es diese Wissenslücken, indem es stilistisch und grammatikalisch korrekte, aber faktisch erfundene Informationen generiert. Ein Grund hierfür ist, dass die Modelle im Training positiver bestärkt werden, wenn sie überhaupt irgendeine Antwort geben als wenn sie zugeben, etwas nicht zu wissen.

Halluzinationen müssen von einfachen Fehlern abgegrenzt werden. Ein einfacher Fehler tritt auf, wenn ein Bot beispielsweise veraltete Öffnungszeiten ausgibt, weil die zugrundeliegende Wissensdatenbank nicht aktualisiert wurde oder ein falsches von zwei im Katalog hinterlegten Produkten auswählt.

Eine Halluzination hingegen ist heimtückischer, da der Bot aktiv Informationen erfindet. Diese Art von Falschinformation ist extrem schwer zu erkennen und birgt weitreichende Konsequenzen für die Kundenzufriedenheit und Compliance.

Rechtliche und finanzielle Risiken

Die wohl unmittelbarsten und teuersten Folgen sind die rechtlichen Konsequenzen. Wenn ein KI-Assistent einem Kunden fiktive Vertragsbedingungen wie im Fall des Air Canada Chatbots verspricht, kann das Unternehmen zur Zahlung einer Entschädigung verurteilt werden. Falsche Angaben in rechtlich relevanten Dokumenten, erzeugt durch einen AI Agent, können zu Haftungsproblemen, Vertragsverletzungen und Compliance-Verstößen führen. Die finanziellen Kosten erstrecken sich bis hin zu massiven Marktwertverlusten.

Reputationsschaden und Vertrauensverlust

Falsche Informationen, die von einem Chatbot oder Voicebot selbstbewusst generiert werden, verbreiten sich heutzutage schnell und können das Vertrauen in Ihre Marke nachhaltig erschüttern. Kundenbeziehungen werden so dauerhaft beschädigt, da Kunden, die sich durch eine falsche Information betrogen fühlen, zur Abwanderung neigen.

Operative Ineffizienz

Anstatt eine Entlastung zu schaffen, führen Halluzinationen zu operativer Ineffizienz. Mitarbeiter sind gezwungen, die Fehler des Bots zu korrigieren, was zu Frustration im Team und einem Mehraufwand führt, der die angestrebten Automatisierungsvorteile zunichte macht.

Lösungen gegen KI-Halluzinationen

Die gute Nachricht für Führungskräfte im Kundenservice ist, dass Halluzinationen von Chatbots oder Voicebots kein unkontrollierbares Schicksal sind, sondern durch einen robusten, mehrschichtigen Ansatz kontrolliert werden können. Dieser Ansatz stützt sich auf vier technologische und prozessuale Säulen, die nahtlos ineinandergreifen, um die Faktentreue und Zuverlässigkeit Ihrer AI Agents signifikant zu verbessern.

Smart Chunking und Vektorisierung

Die Basis für zuverlässige Botantworten ist ein gut aufbereiteter Wissenspeicher. Dieser Prozess ist untergliedert in Chunking und Vektorisierung.

Beim Chunking werden große Datenmengen in kleinere Informationseinheiten (Chunks) zerlegt. Die für das Generieren der Antwort verwendeten Chunks sollten kohärent und vollständig sein. Häufig passieren hier Fehler wie, das simple Zerlegen nach einer festen Zeichenanzahl, bei dem ein Satz in einem Chunk beginnen und in einem anderen enden kann.

Die ideale Variante ist daher das Smart Chunking oder inhaltsbasiertes Chunking. Hierbei wird die Dokumentenstruktur genutzt (beispielsweise Überschriften oder Formatierungen) um logische und inhaltlich abgeschlossene Abschnitte zu generieren.

Beispiel: Bei einem Maschinenbauunternehmen mit verschiedenen Maschinenmodellen muss jeder Chunk, der technische Details enthält, die exakte Maschine und das Modell nennen, auf das sich die Information bezieht.

Im Anschluss an das Chunking wird jeder Text-Chunk in einen Vektor umgewandelt. Ein Vektor ist eine numerische Repräsentation, die die semantische Bedeutung des Textes in einem hochdimensionalen Raum erfasst. Dieser Schritt ist essentiell, da bei der späteren Suche die ebenfalls vektorisierte Kundenanfrage höchst präzise mit den vorhandenen Chunks auf semantische Ähnlichkeit verglichen werden kann.

Retrieval-Augmented Generation (RAG)

Das Implementieren einer RAG-Architektur ist eine effektive Methode um das Erfinden von Informationen zu verhindern und das LLM zu zwingen, sich an die Realität zu halten. RAG stattet das Modell mit einem externen, verifizierten Wissensspeicher (z. B. FAQs, interne Handbücher) als Single Source of Truth aus, sodass es sich nicht nur auf seine eigenen, potenziell fehlerhaften Trainingsdaten verlässt

Jede Nutzeranfrage wird so in vier Schritten verarbeitet:

- Zuerst wird die Anfrage interpretiert.

- Dann durchsucht das System in der Retrieval-Phase Ihre verifizierte Wissensdatenbank nach relevanten Fakten.

- Erst in der Augmentation-Phase werden diese Fakten als klarer Kontext zusammen mit der ursprünglichen Frage an das LLM übergeben.

- Schließlich formuliert das Modell in der Generation-Phase eine natürliche Antwort, die strikt auf den verifizierten Fakten basiert.

- Fortschrittliche Systeme machen in einem weiteren Schritt noch einen finalen Fakten Check gemacht, in dem die generierte Antwort gemeinsam mit den Fakten noch einmal gegengeprüft wird.

Mit diesem Ansatz wird die Wahrscheinlichkeit, dass der AI Agent halluziniert, drastisch gesenkt. Dies führt direkt zu einer höheren Erstlösungsquote (FCR) und einer geringeren Eskalationsrate, da Kunden verlässliche Antworten erhalten.

Intelligente Guardrails & Prompt Engineering

Während RAG regelt, was der Bot sagt, bestimmen Guardrails und Prompt Engineering, wie er es sagt und worüber er sprechen darf.

Guardrails sind programmatische Regeln, die dem KI-Modell klare, vordefinierte Grenzen setzen. Beispiele hierfür sind thematische Beschränkungen, das Verbot, nicht autorisierte Versprechungen oder Garantien zu machen, und die Einrichtung von Sentiment-Analysen, die bei hochgradig verärgerten Kunden sofort eine proaktive Übergabe an einen menschlichen Mitarbeiter auslösen.

Ergänzend dazu sorgt präzises Prompt Engineering für einen unmissverständlichen Handlungsrahmen. Ein optimierter System-Prompt kann das Modell anweisen, Fragen ausschließlich auf Basis des bereitgestellten Kontexts zu beantworten. Sollte die Information fehlen, wird das Modell angewiesen, Unsicherheit einzugestehen und an einen menschlichen Kollegen zu übergeben, anstatt zu raten.

Human-in-the-Loop

Trotz aller Technologie bildet eine menschliche Aufsicht die dritte, unverzichtbare Säule. Der Human-in-the-Loop-Ansatz integriert menschliche Intelligenz gezielt in den KI-Prozess, um als ultimatives Sicherheitsnetz und Qualitätssicherer zu dienen.

Gespräche, bei denen der Bot unsicher war oder die vom Kunden negativ bewertet wurden, sollten von Mitarbeitern gesichtet werden und die Korrekturen direkt als Lernfeedback ins System zurückfließen.

Klare Eskalationspfade sorgen außerdem für einen nahtlose Übergabe vom Bot an einen menschlichen Agenten, sobald die Konversation zu komplex oder emotional wird.

Bereit für eine zuverlässige KI-Zukunft?

Der Erfolg Ihrer Conversational-AI-Strategie steht und fällt mit der Eindämmung der Halluzinationen Ihres AI Agents. BOTfriends ist Ihr strategischer Partner, um diesen Maßnahmen umzusetzen.

Unsere Plattform ist von Grund auf darauf ausgelegt, die Risiken generativer KI zu minimieren.

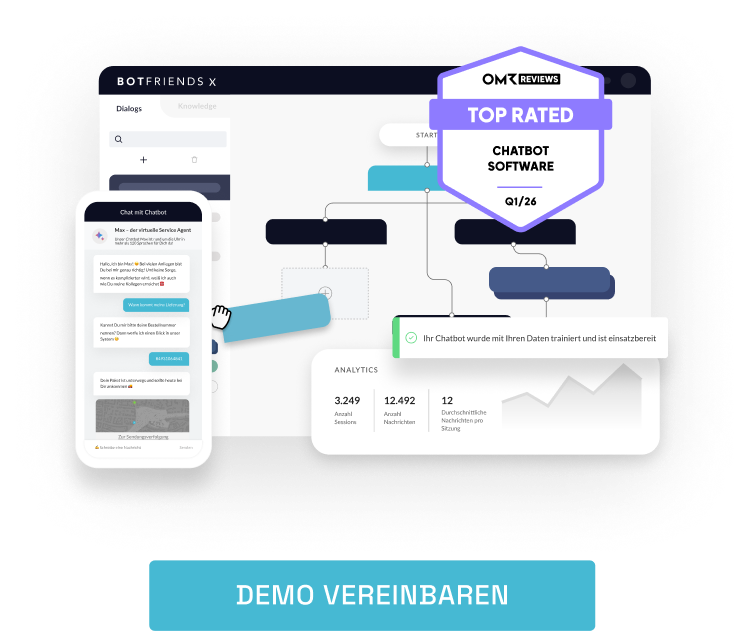

- Per API, Dokumentenupload oder URL Scraping bauen Sie Ihre Wissensdatenbanken mühelos auf und schaffen dank Smart Chunking ein robustes RAG-System.

- Dank des zusätzlichen Faktenchecks werden Antworten nur dann ausgespielt, wenn eine Confidenceschwelle überschritten ist.

- Im Gegensatz zu anderen Anbietern können Sie mit BOTfriends X Ihren Bot anweisen, nicht zu antworten, wenn er sich nicht sicher ist oder Rückfragen zu stellen, um das Thema besser zu verstehen.

- Über die Definition von umfangreichen AI Agent Personas können Sie mit vordefinierten Einstellungsmöglichkeiten oder Freitext präzise Guardrails und Verhaltensweisen ganz ohne Code festlegen.

- Wir bieten die nötigen Analyse- und Monitoring-Tools, die Ihnen transparente Einblicke geben, auf welcher Wissensquelle eine Antwort basiert, und ermöglichen so eine lückenlose Nachverfolgung der Antwortgenerierung.

Die Frage ist heute nicht mehr, ob Sie generative KI einsetzen, sondern wie Sie sie sicher, verantwortungsvoll und kontrolliert in Ihre Prozesse integrieren. Zwar werden LLMs laufend optimiert, um Halluzinationen zu erkennen, möchten Sie aber auf Nummer sicher gehen und sich von der Konkurrenz abheben, sollten Sie mit einer Plattform wie BOTfriends X nichts dem Zufall überlassen.

AI Agent ROI Rechner

AI Agent ROI Rechner Kostenloses Training: Chatbot Crashkurs

Kostenloses Training: Chatbot Crashkurs Whitepaper: Die Akzeptanz von Chatbots

Whitepaper: Die Akzeptanz von Chatbots